文 | HW君

本文为B站【V9】期的视频讲稿。

有部分动态演示,请以视频画面为准。

人眼基于深度的体积感知,为何VR影像需要通过FOV标准化【双目VR摄影#V9】

0. 空间中的体积感知

不知道你有没有想过,我们是如何判断一个物体的体积大小的。

有些东西看上去很小巧玲珑、袖珍迷你。

而另一些东西则让人感觉庞然大物,有压迫感。

那么是哪些因素造成了这种心理感受,而这种心理感受又与VR影像有什么关系呢?

消失的模因,大家好,我是HW君。欢迎来到【V9】期,也就是「双目VR摄影」系列的第9期。

【V系列】狭义上讨论的话题是,如何拍摄与制作「VR影像」,广义上探讨的则是「摄影」「光学」「VR」这三个学科的交叉地带。

上一期我们讨论了如何正确理解「VR设备」本身的FOV,而这一期开始我们将会讨论如何理解「VR影像」的FOV。

这些原理可能不是那么有趣,但长期来看,如果我们追求VR影像的「身临其境」,想要在VR眼镜里复现出这个世界上另一个地方的真实场景,那么就总会遇到这些问题。

1. FOV张角的近大远小

我们是如何判断一个物体的体积大小的呢?

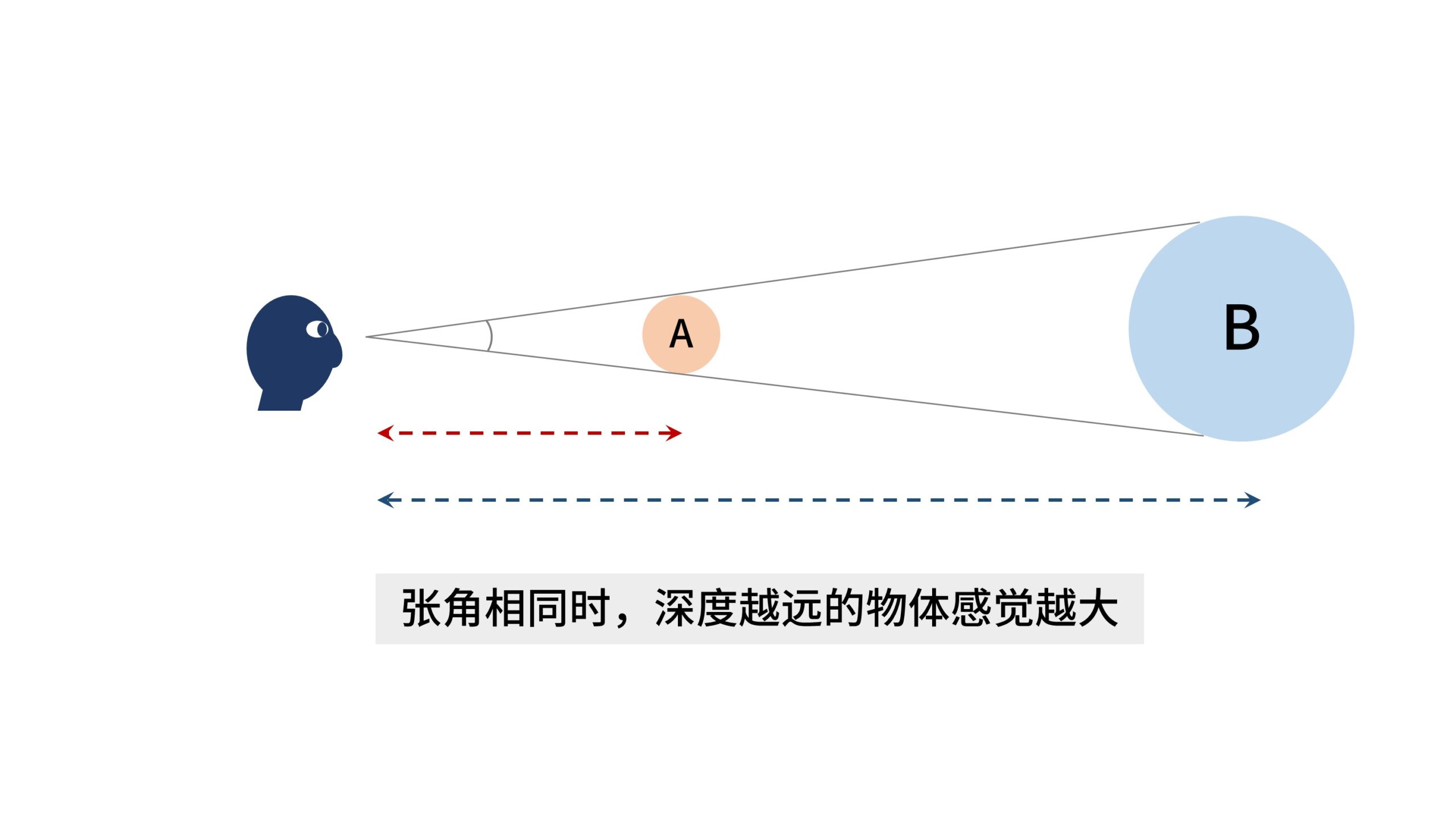

如图,假设在一个无参照物的环境里有两个小球,我们能说这里小球A的体积要比小球B的要大吗?

似乎并不能,因为我们不知道2个小球各自离我们的距离。

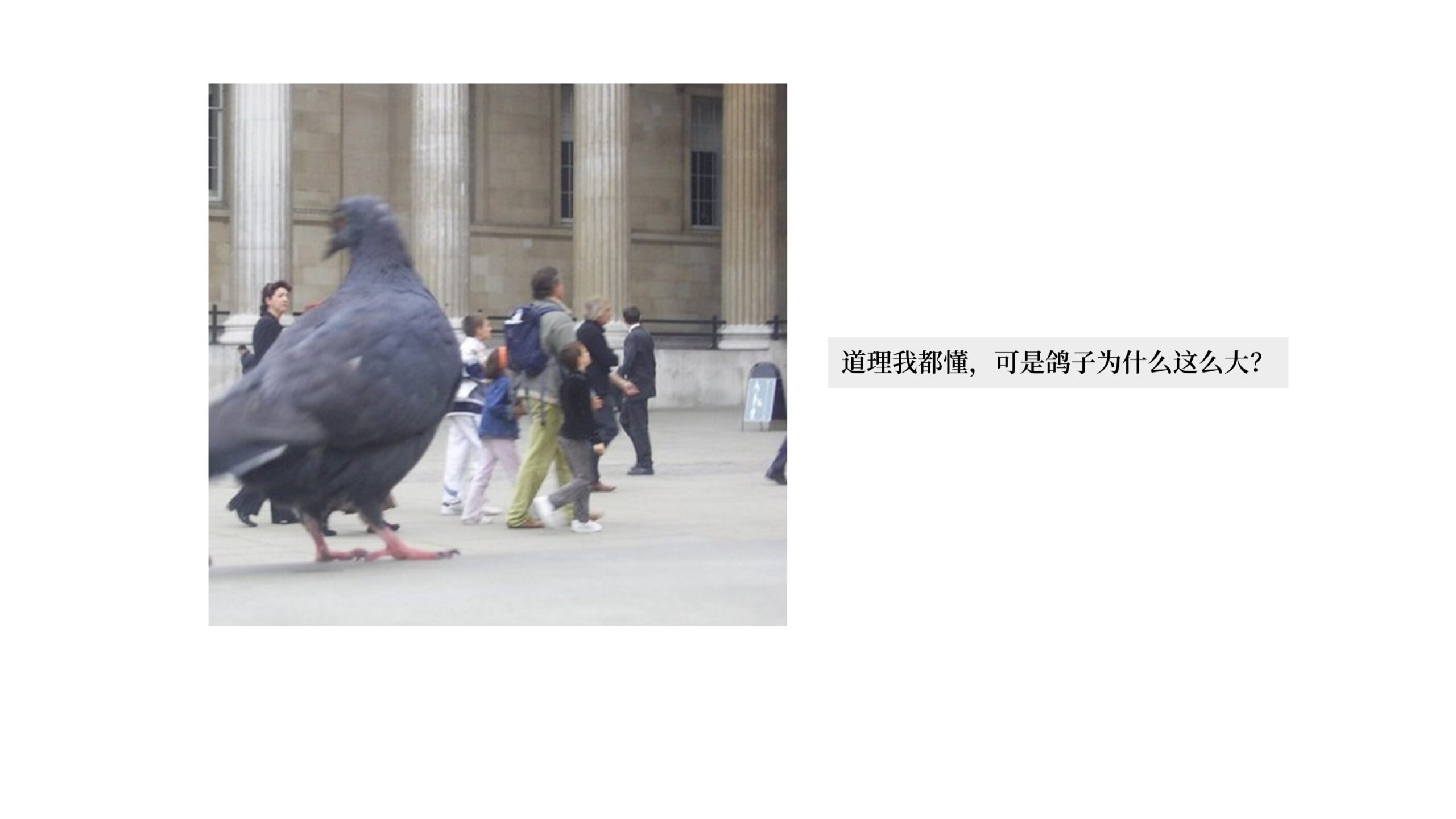

有一张著名的图片很好地说明了这一问题,为什么鸽子这么大?

因为鸽子离人近。

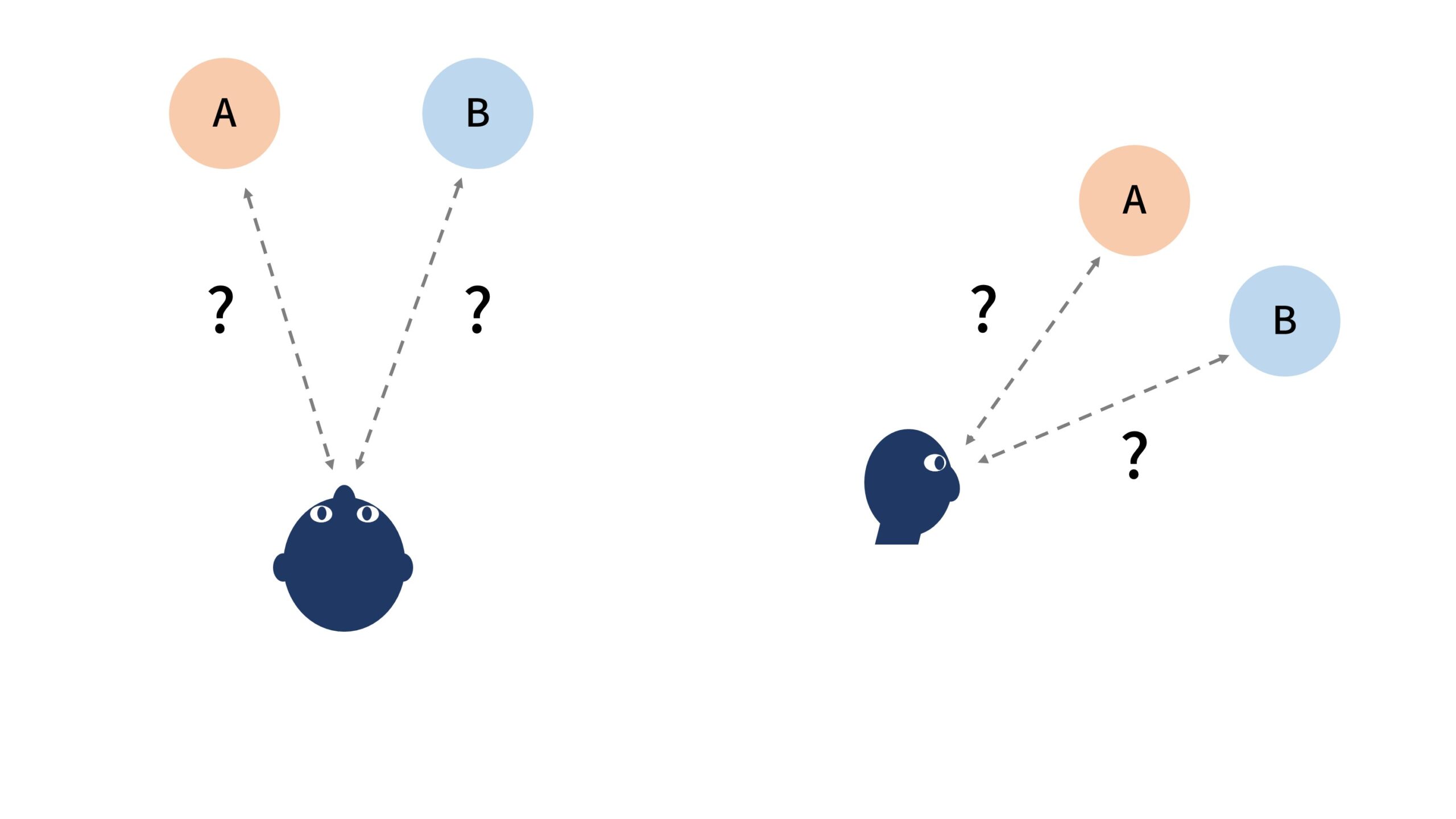

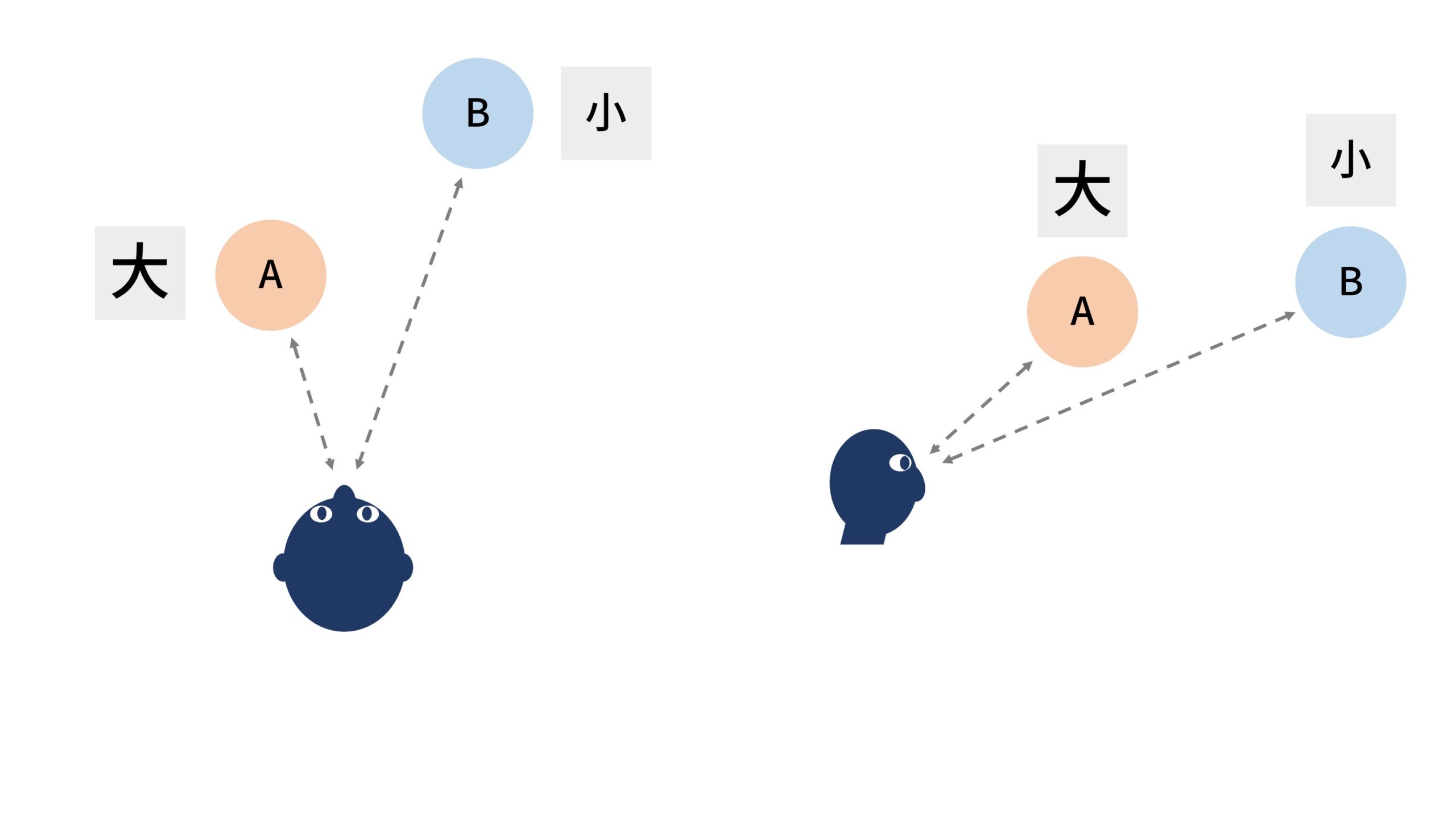

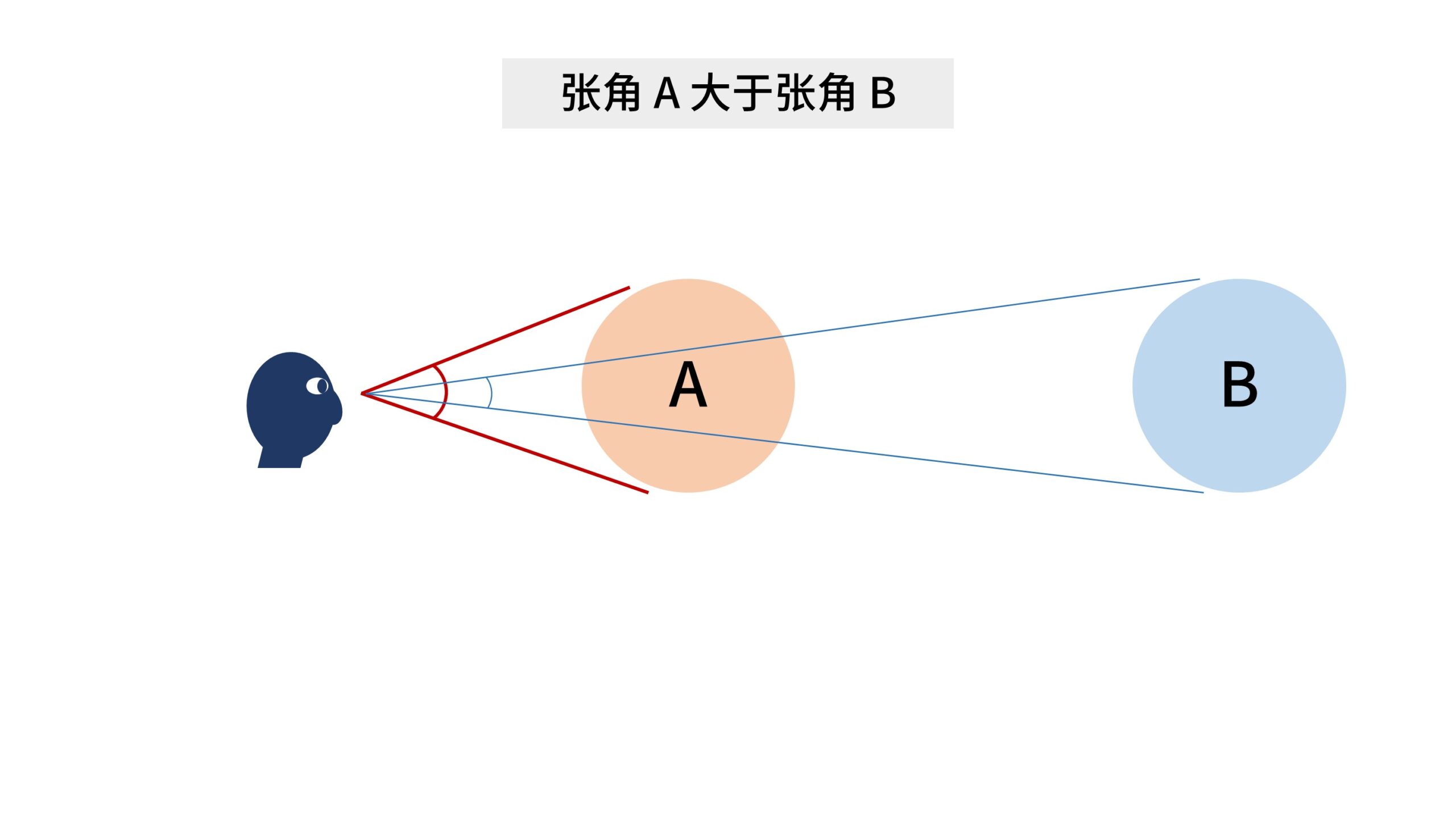

假设2个小球的体积完全相同,那么在人眼看来,距离比较近的小球A,看上去会比距离比较远的小球B大。

有个通俗易懂的词语就是形容这个现象的,叫「近大远小」。

同一个物体,离得近就显得大,离得远就显得小。

那在人眼看来,这种直观的「大」和「小」究竟指什么呢?

其实指的是物体相对于人眼视点所张开的角度的大小,即物体的FOV。

那因为上一期【V8】期里我们讨论了VR设备的几类FOV,为了避免产生混淆。

《VR | #8 你真的理解VR的FOV吗?如何科学地佩戴VR眼镜》

http://gonememe.com/archives/7436

在这里我会将VR画面中「物体的FOV」称为「物体的张角」,它们表达了同一个意思。

所以对于人眼来说,那个直观的「近大远小」,其实指的是物体张角的大小。

同一个物体,离得近张角就大,离得远张角就小。

当然在实际情况中,我们是直接通过眼睛看到物体的张角的大小。

然后再加上物体的深度,就可以感知出物体的体积。

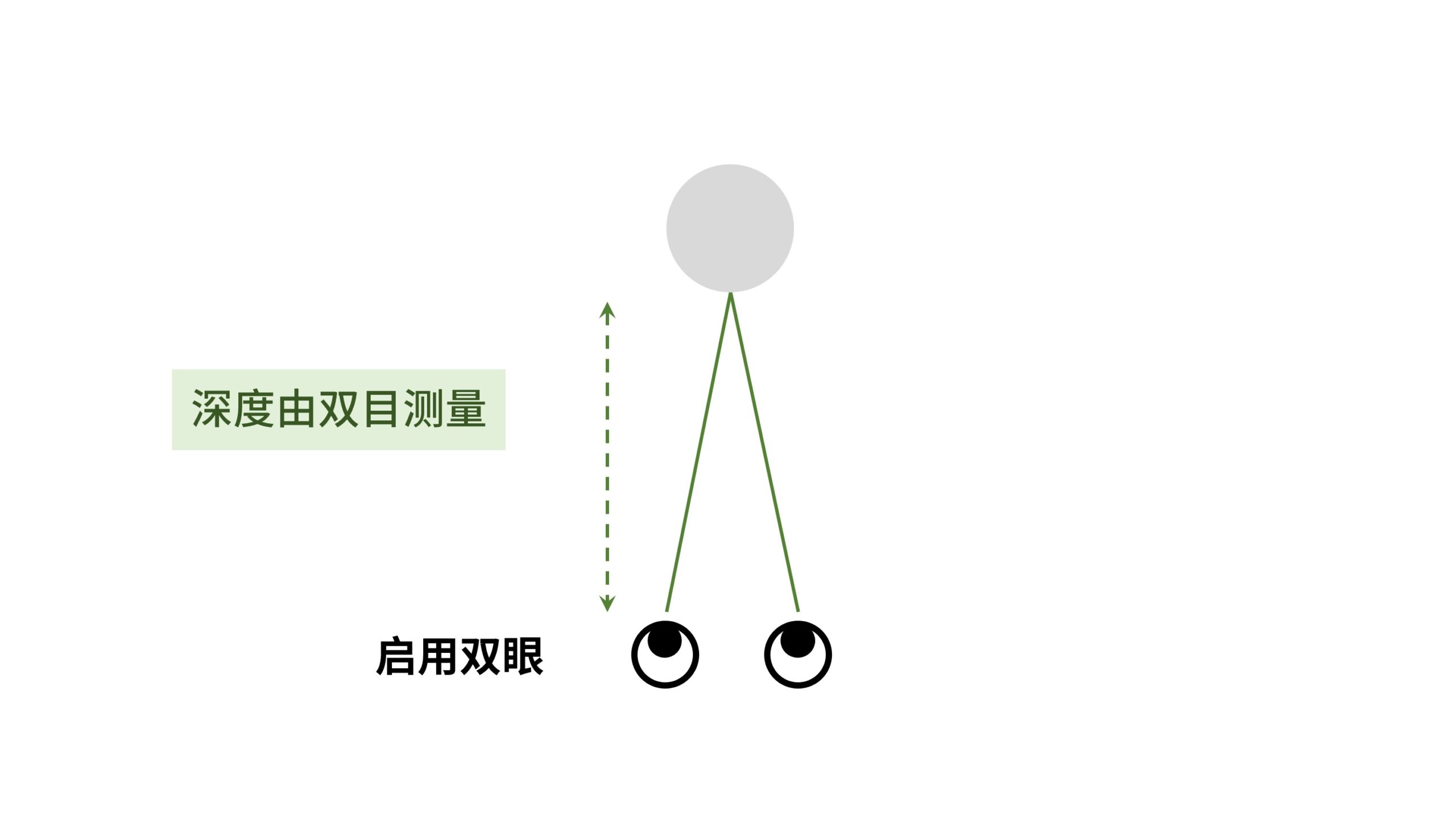

2. 双目深度的高优先级

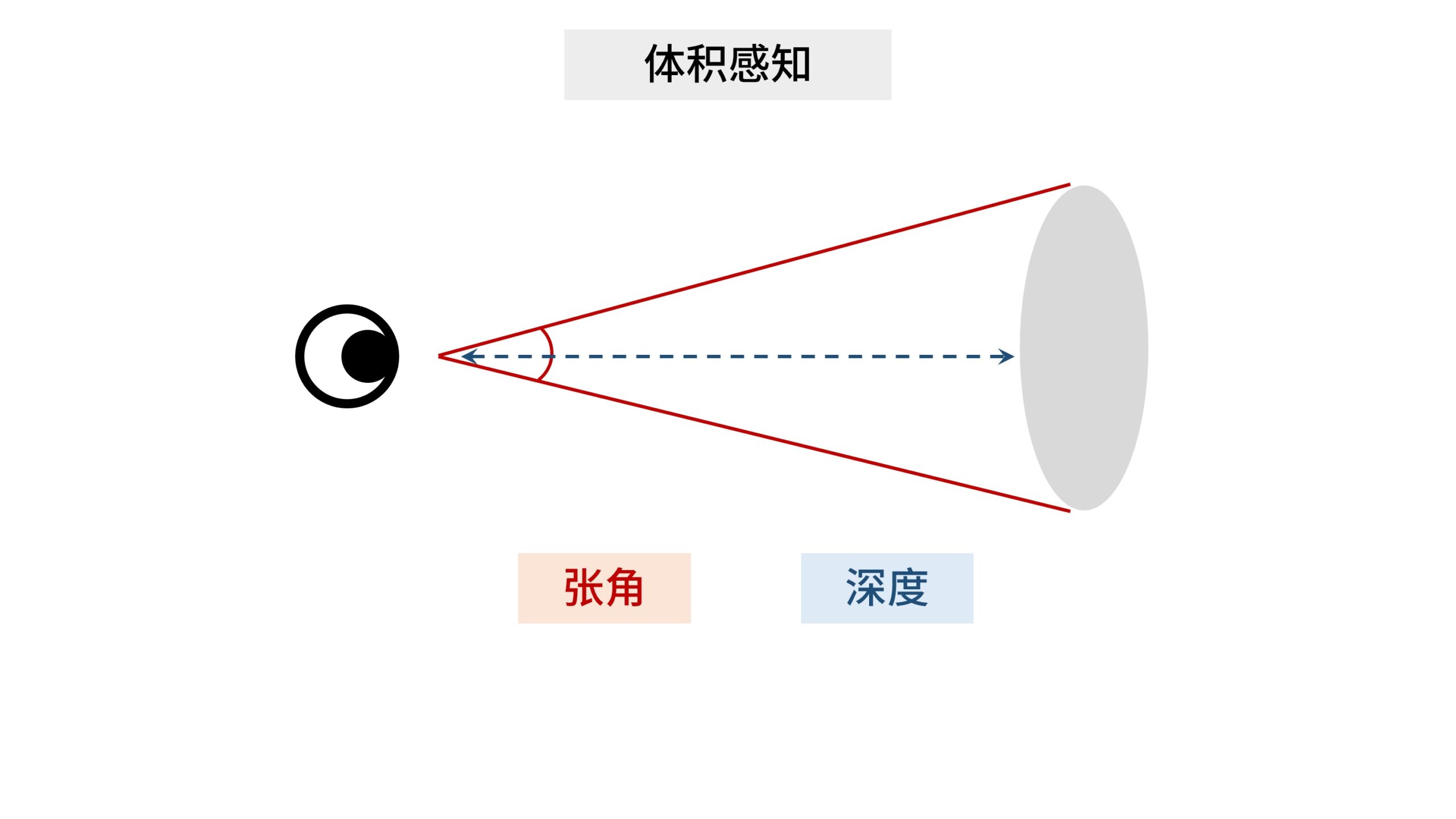

人类在三维空间中的体积感知能力,涉及到2个要素,一个是物体的张角(FOV),另一个就是物体的深度。

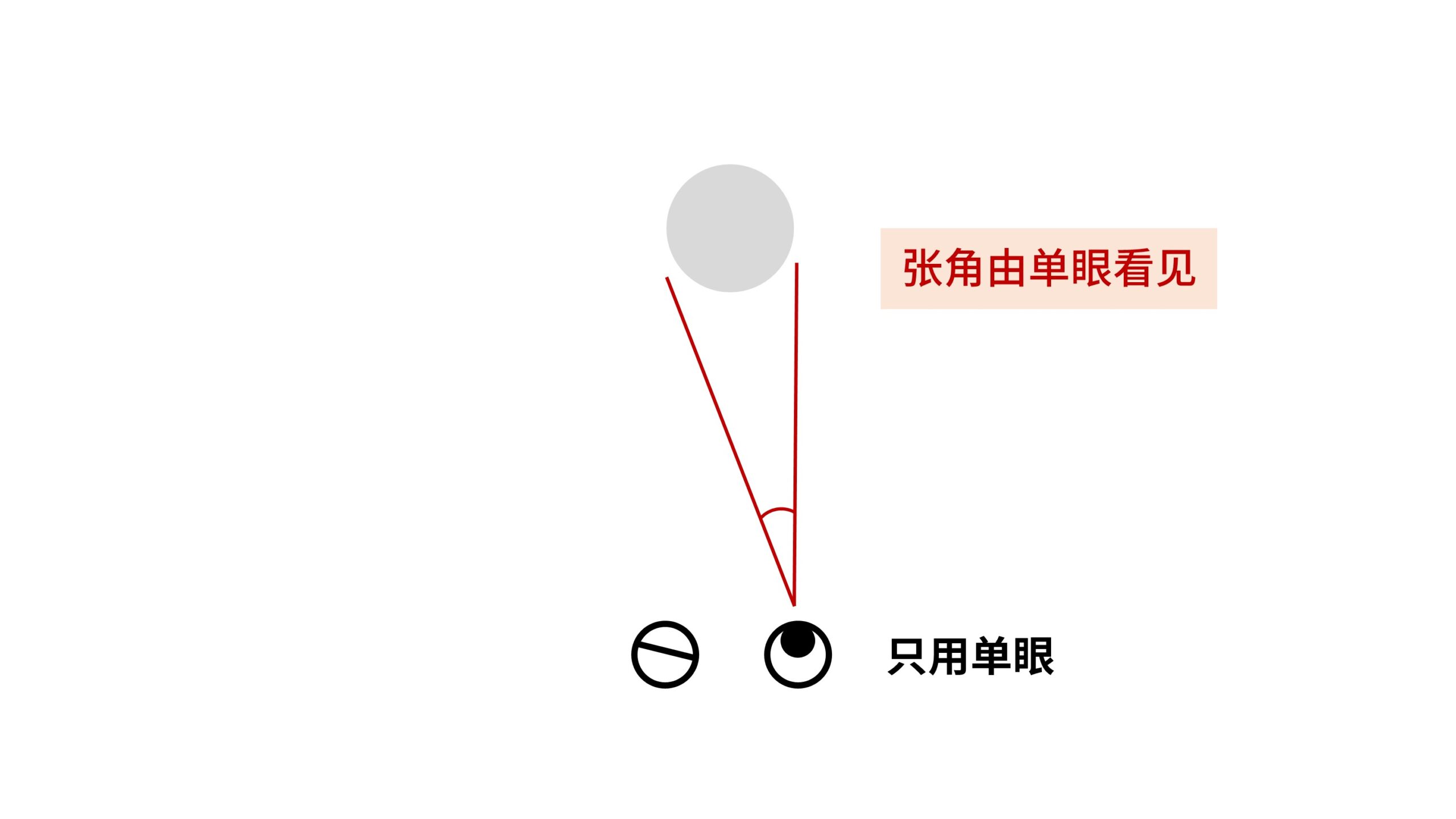

对于物体的张角,我们依靠单眼就可以直接看到,而对于物体的深度感知,则比较多样化。

我们在【V1】期里有说过,人眼对于深度信息的获取,其优先级从高到低,大致上按照如下顺序排列。

双目汇聚、双目视差、单眼聚焦、大脑补充。

http://gonememe.com/archives/7211

即双眼线索的优先级通常会高于单眼。

这就可以解释在【V3】期里,因为摄距与瞳距不同导致的深度感知异常。

实际上不只是深度感知异常,它还导致了体积感知异常。

《VR | #3 瞳距有什么用?为何到PICO 4才算是合格的VR视频机》

http://gonememe.com/archives/7333

在【V3】期里,无论摄距远大于瞳距,还是摄距远小于瞳距,拍出来的双目VR影像,如果只使用单眼观看,是不会发现有问题的。

只用单眼观看时,深度是正常的,体积也是正常的,人物大小的比例感觉上都是正常的。

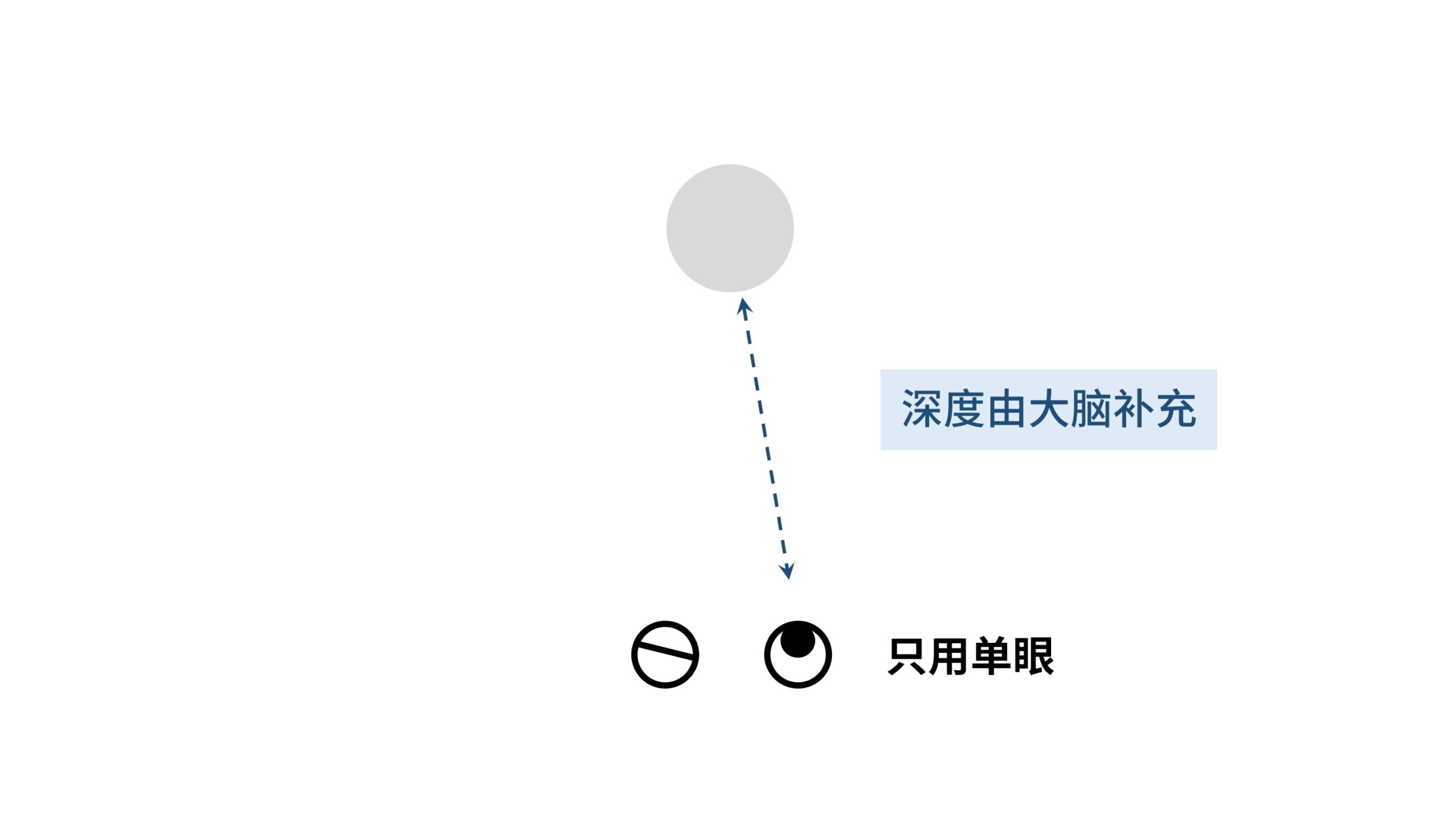

因为用单眼观看时,体积感知里的2个要素,张角和深度,其信息都来自于单眼线索。

张角直接被单个眼睛看见,而深度则由「大脑补充」产生。

大脑会依据单眼画面补充一个符合逻辑的深度,由此最终产生的体积感知也不会有异常。

而当我们切换到双眼时,因为双眼的优先级大于单眼,此时深度感知切换到「双目汇聚」和「双目视差」,人脑直接硬解出了基于双眼线索的深度信息。

而因为摄距不符合人眼瞳距,基线出现错误,因此人们感知到的「深度」是异常的,最终导致对画面的「体积感知」也出现了异常。

所以当摄距远大于瞳距,在回看时人眼感知的「深度」会变近,相同「张角」下的体积感知会变小,因此猛汉子看上去小鸟依人。

而当摄距远小于瞳距,在回看时人眼感知的「深度」会变远,相同「张角」下的体积感知会变大,因此萌妹子看上去像巨人。

而在遇到此类问题时,如果我们闭上一只眼睛,屏蔽掉高优先级的异常双目深度,那么大脑会根据单眼画面脑补一个深度,此时体积感知就恢复正常。

那这个特性也有个小应用。在观看一些单目2D的360°或180°全景视频时,因为缺乏双目视差,近处的人物常常会巨人化。

而只要闭上一只眼睛,屏蔽双眼对于深度的获取,那么画面的体积感知就会恢复。

而理解了这一点,我们也就会知道现在很多AR投屏眼镜所宣传的「观看效果多少米多少英寸」是怎么一回事。

例如所谓的4米130英寸,10米330英寸这些,实际上这些数字是没有什么参考价值的。

我们只需要知道虚像画面的张角(FOV)是多少就行了。

因为这些AR投屏眼镜都是双目设备,通过双目视差的偏移调整,可以创造几乎任意的双目深度。

而虽然屏幕本身有一个基于单眼的「虚像距」,但这个单眼深度会被高优先级的双眼深度所屏蔽。

于是你觉得眼前小FOV的屏幕在非常远的位置,你觉得自己在看一个巨幕,因为你的「体积感知」被影响了。

但实际上你能看到的FOV并没有发生改变。

3. 标准化与身临其境

相机摄距和人眼瞳距的一致,保证了正确的双目深度。

而图像FOV的标准化则保证了正确的张角。

深度和张角共同影响了人类在三维空间中的体积感知。

所以在双目VR摄影里,除了要保证摄距和瞳距的一致,VR影像也需要通过FOV来标准化,这样才能产生正确的体积感知,以让我们感受到「身临其境」。

那瞳距/摄距之类的话题,慢慢也有人意识到了。

但对VR影像进行FOV标准化的事情,似乎还没有多少人能够正确认识到。

而这一问题正是传统的非标的平面3D视频的困境所在。

为什么长期以来平面3D视频都没有很好的发展。

好莱坞3D电影一直无法掀起波澜,十多年前的3D电视行业为何完全死掉了。

这一切都跟平面3D影像没有实现标准化有关。

「平面3D影像」在深度和张角上都没能进行标准化,由此产生了非常多难以解决的问题。

而这些问题在VR设备所创造的虚拟空间里,终于有了解决的可能性。

那这一期就先到这里了。

我是HW君,我们下期再见。

(本章节完)

By HW君 @ 2023-09-23