文 | HW君

本文为B站【K4】期的视频讲稿。

通往Vision之路【空间影像#K4】

0. 何为Vision

我一直都不是果粉,对乔布斯没有什么过多的敬仰,更别说库克了。

但去年6月WWDC上,库克出来讲「one more thing」的时候,我确实看到了他的眼睛里有光,他坚信这就是未来。

本可以平稳地从苹果退休的他,似乎把晚节都压在了Vision Pro上了。

我突然意识到库克和扎克伯格其实是同一类人,他们在赌同样的事,只是库克手里有比小札更多的筹码。

与此同时大洋这边的雷军,也在做类似的事情,只不过赌的方向不同。

我想起很多年前读过的《浪潮之巅》,近一百年来的科技革命就像浪潮一样一波又一波,总有一些个体或者群体很幸运地、有意识或无意识地站在了科技革命的浪尖之上。

今天所有人都意识到了,移动互联网的旧时代快要结束了,那么新世界会在哪里呢?

若我还是多年以前的那个年轻人,大概会喜欢此类让人热血的宏大叙事。

但多年过去后热血不再,我的世界观也坍缩成了「信息论」。

新世界在哪里我并不知道,但我们能看懂苹果做事的内在逻辑。

苹果做的每一件事情,都会让信息更多更快地流动。

事实上当听到苹果将头显命名为「Vision」时,我想到了很多事情。

Vision这个词并不是第一次出现在苹果的产品里。

从2020年发布iPhone 12开始,苹果开始支持HDR视频的拍摄,其使用的HDR规格叫「杜比视界」,英文名为「Dolby Vision」。

要知道苹果Vision 产品团队的负责人Mike Rockwell,在2015年入职苹果之前曾就职于杜比实验室,我不认为「Vision Pro」和「Dolby Vision」的这两个「Vision」只是巧合。

很多人并不知道「Vision」这个词到底意味着什么,也没有理解苹果这些年围绕「Vision」都做了些什么事情。

1. 从光场说起

消失的模因,大家好,我是HW君。

欢迎来到K4期,也就是「空间影像」系列的第4期。

VR是完全接管人类「视觉」的显示设备,要理解这个「Vision」,不妨从理解更底层的「光场」概念开始。

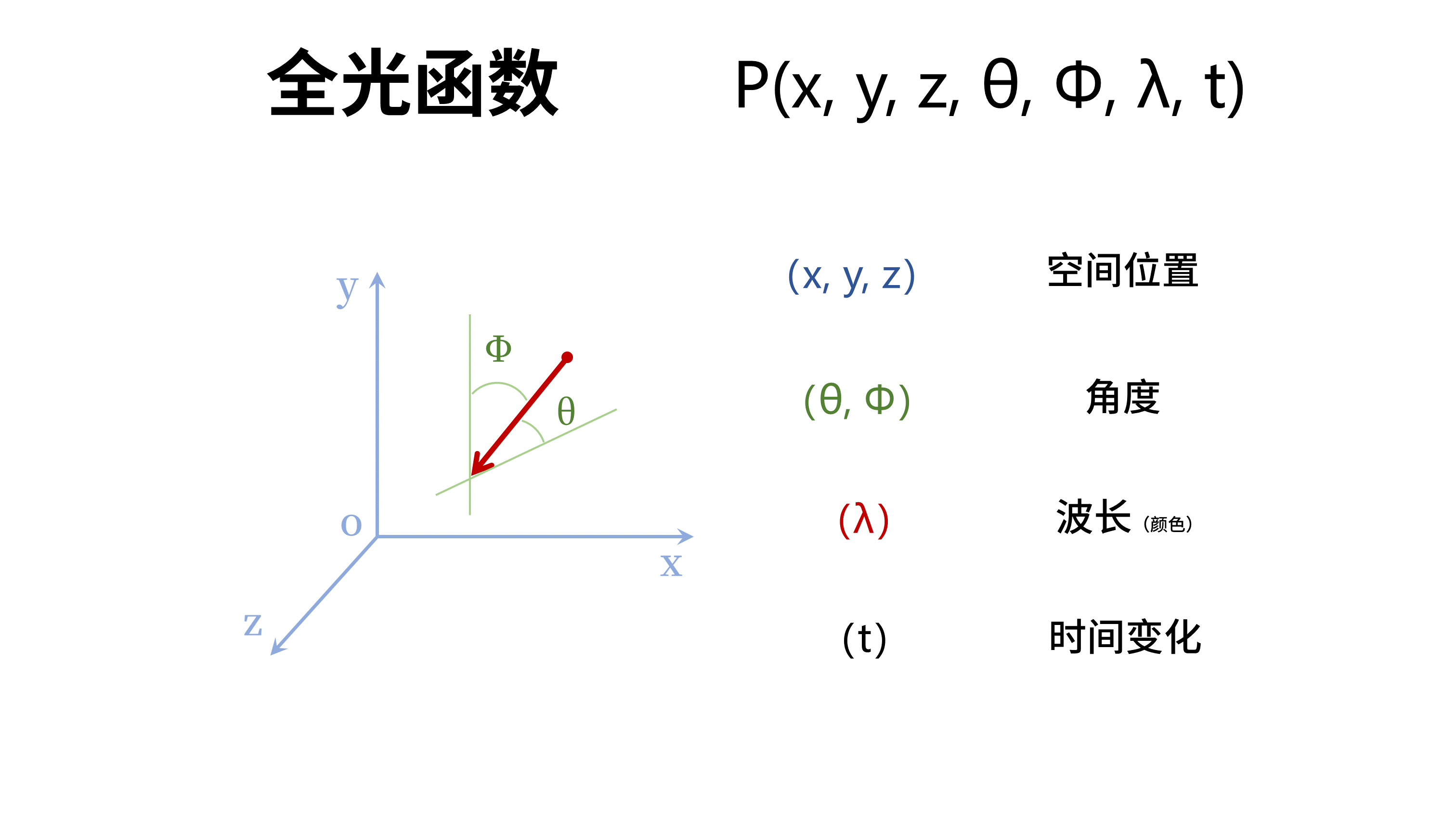

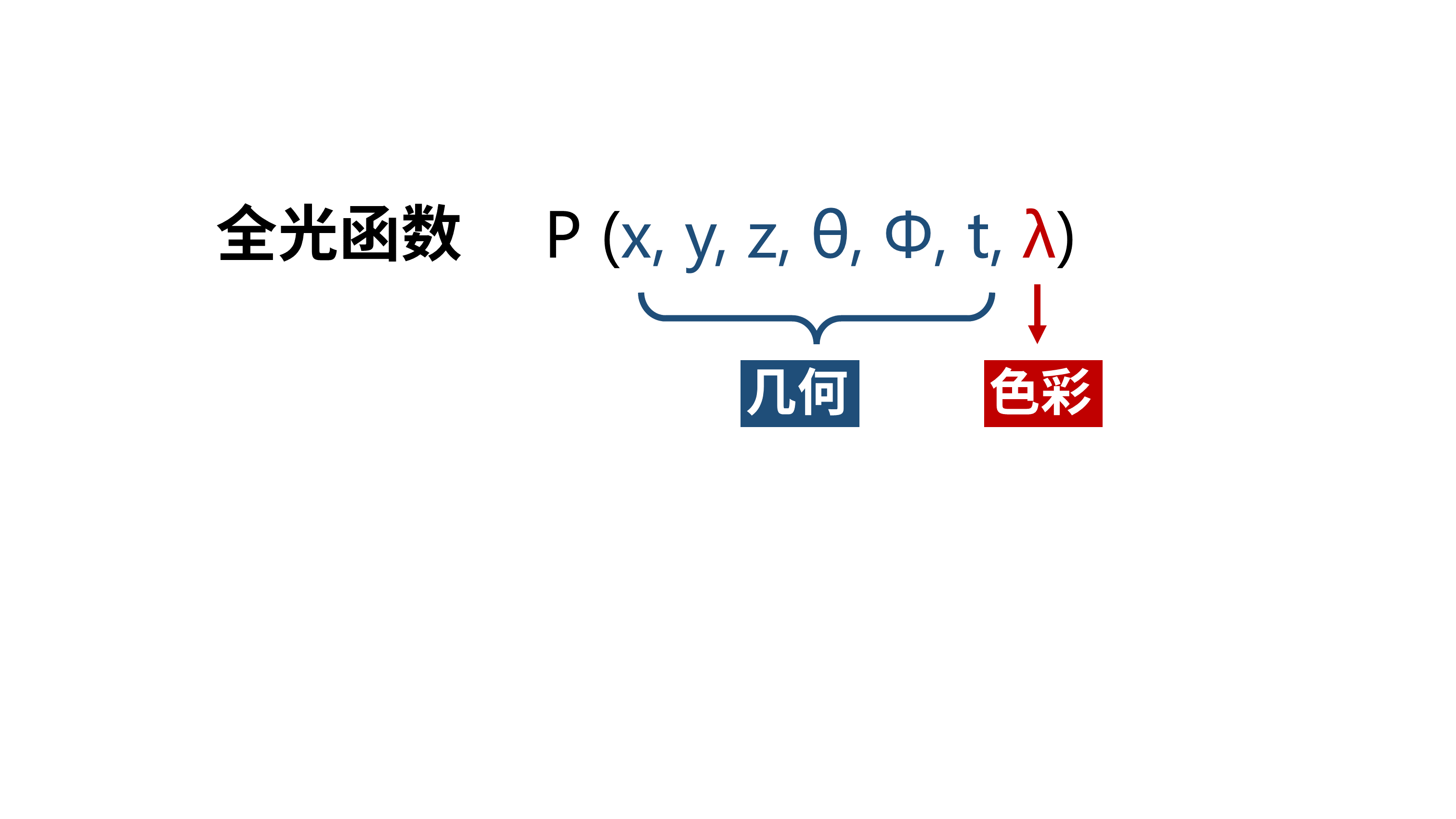

我们可以用7个变量来完备地描述人眼在空间中看到的光线的所有信息。

得到这样的一个函数:P(x, y, z, θ, Φ, t, λ)

其中前三个变量(x, y, z)描述光线的空间坐标位置。

而 (θ, Φ) 表示水平夹角和垂直夹角,它们描述了光线的角度。

变量 (λ) 则是光的波长,它描述了光线的颜色。

最后是时间(t),它描述了光随时间的变化情况。

当然光的物理属性远不止这7个,还有偏振、相位等等。

但对于人眼的视觉感知来说,有这7个变量就已经够了。

依靠这7个变量,可以完备地描述观察者看到的光线的所有信息,所以这个函数叫「全光函数」。

而「光场」其实就是空间中所有「全光函数」的集合。

我们可以把这类具有7个变量的「光场」叫做「7维光场」。

那么完整的「光场采集」,就是获取某个空间里所有光线的这7个变量的信息。

而反过来的「光场显示」,就是在空间中重建带有这7个变量信息的所有光线。

我们在科幻电影里经常能看到神奇的「全息影像」。

这里「全息」的意思就是指「全部的信息」。

对于「7维光场显示」来说,会要求在空间里重建光线7个变量的全部信息。

但事实上人类目前的技术还做不到这一点。

我们只能重建部分变量的信息。

也就是人类目前所有的显示技术都是不完备的「光场显示」,远达不到7维。

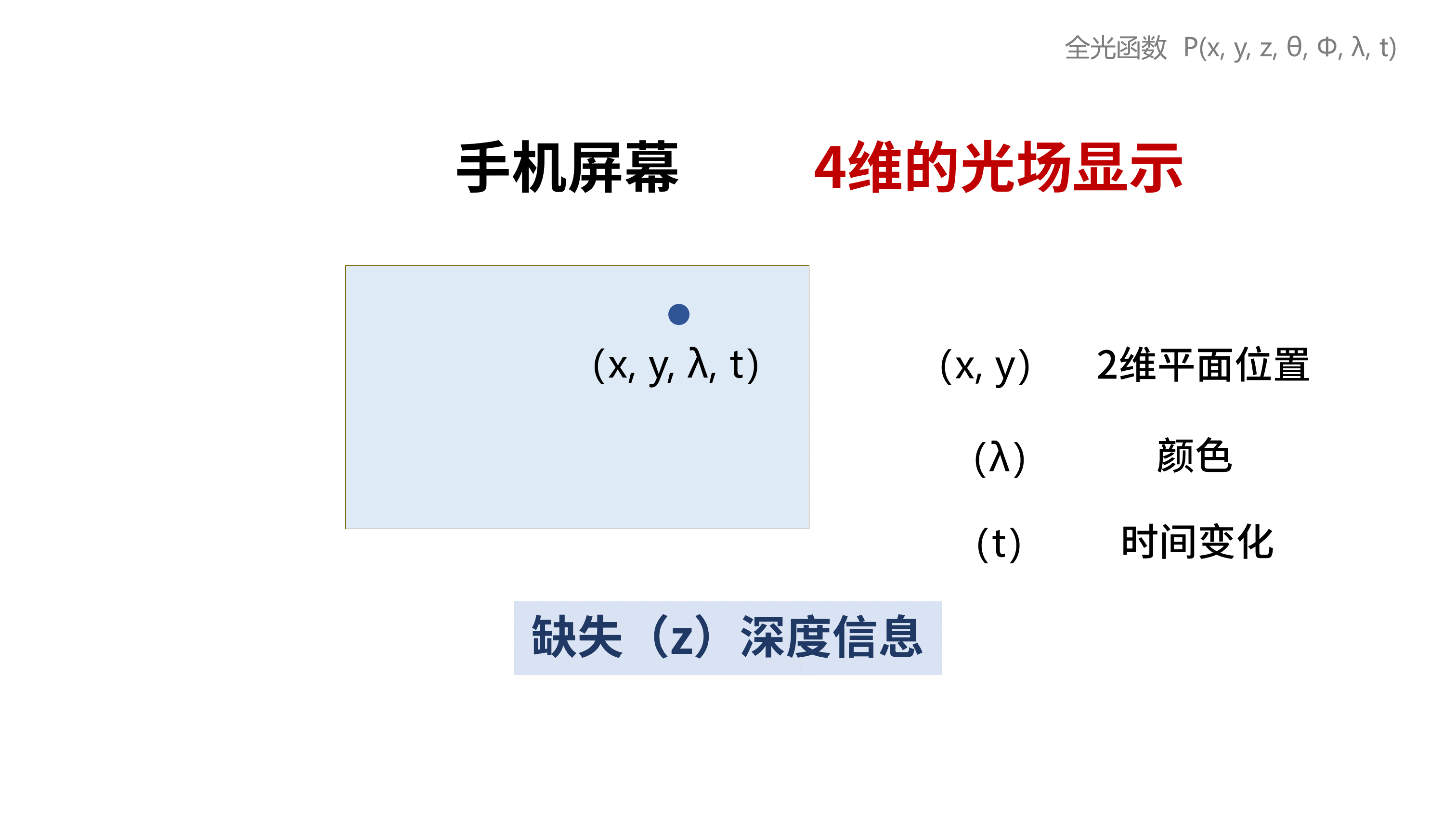

像我们最常见的手机或者电脑的屏幕,它只能显示7个变量中的4个,R(x, y, λ, t)

其中 (x, y) 是屏幕像素点的平面坐标,(λ) 是颜色,(t) 是时间。

因此这种2D平面的手机屏幕,它就可以算是「4维光场显示」。

手机屏幕是没有3D立体效果的,没有 (z) 变量的信息,也就是没有「深度信息」。

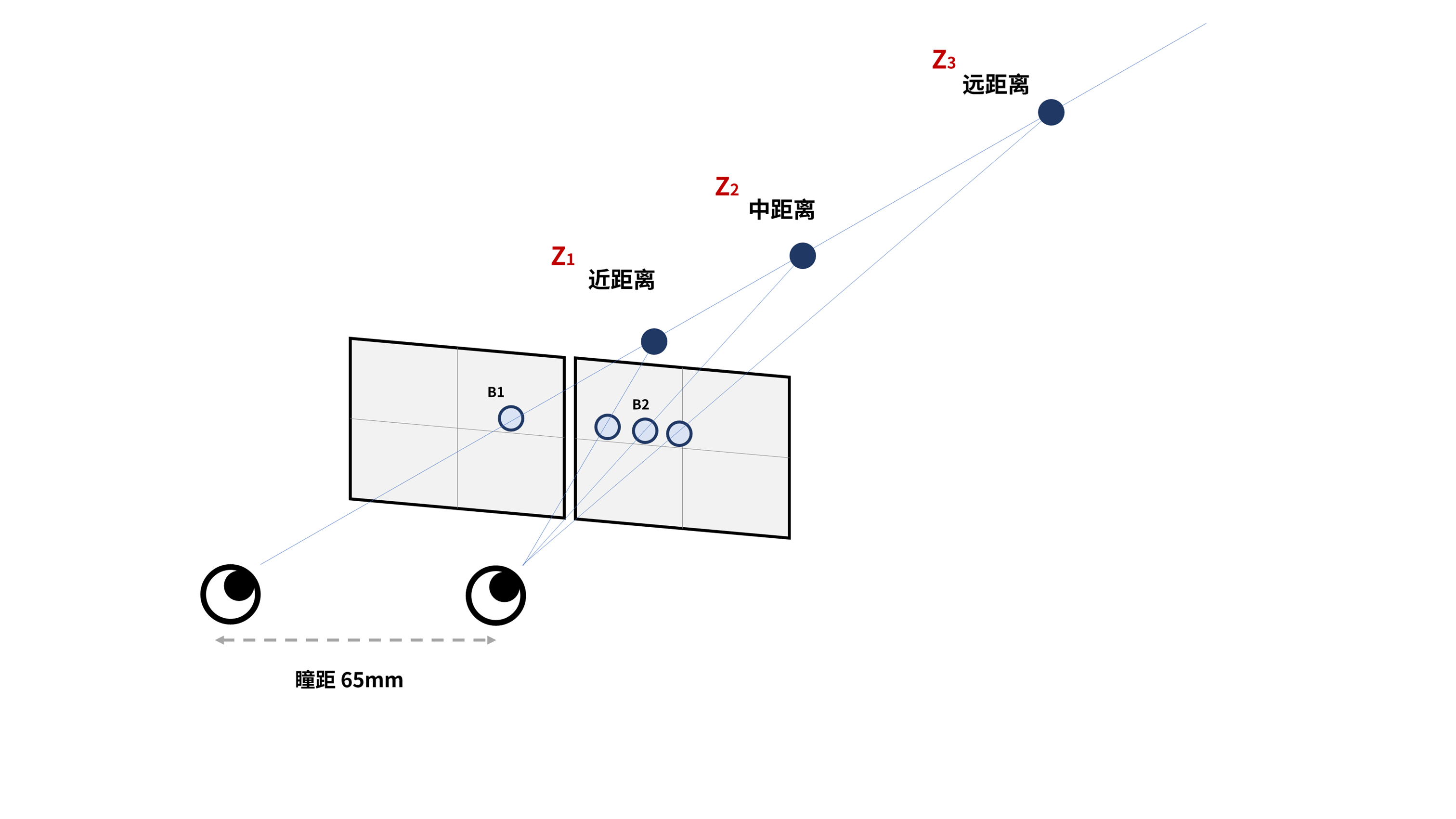

而VR眼镜利用「双目视差」,可以用2幅画面编码一个深度信息 (z),我们的大脑能通过双眼来硬解出这个深度信息 (z)。

这就是VR这种双目显示设备相对于传统2D屏幕来说升维的地方。

传统2D屏幕是「4维光场」显示器,而VR是「5维光场」显示器,多了一维基于「双目视差」的深度信息,多了变量(z)。

当然这里的深度信息(z)并不是完整的,它只是利用了人类「双目视差」的生理机制,而并非真正在空间中重建z轴上的光线。

而人类除了「双目视差」还有「单眼聚焦」的机制,这就导致了「VAC问题」,也就是所谓的「辐辏调节冲突」。

对这一部分有兴趣的朋友,可以看「双目VR摄影」系列的【V1】期。

GoneMeme.com/archives/7211

因为「双目视差」的优先级高于「单眼聚焦」,所以对于人类来说,VR确实是一种「5维光场」显示器。

而回顾显示技术的进步方向,其实就是在不断地逼近完整的光场显示。

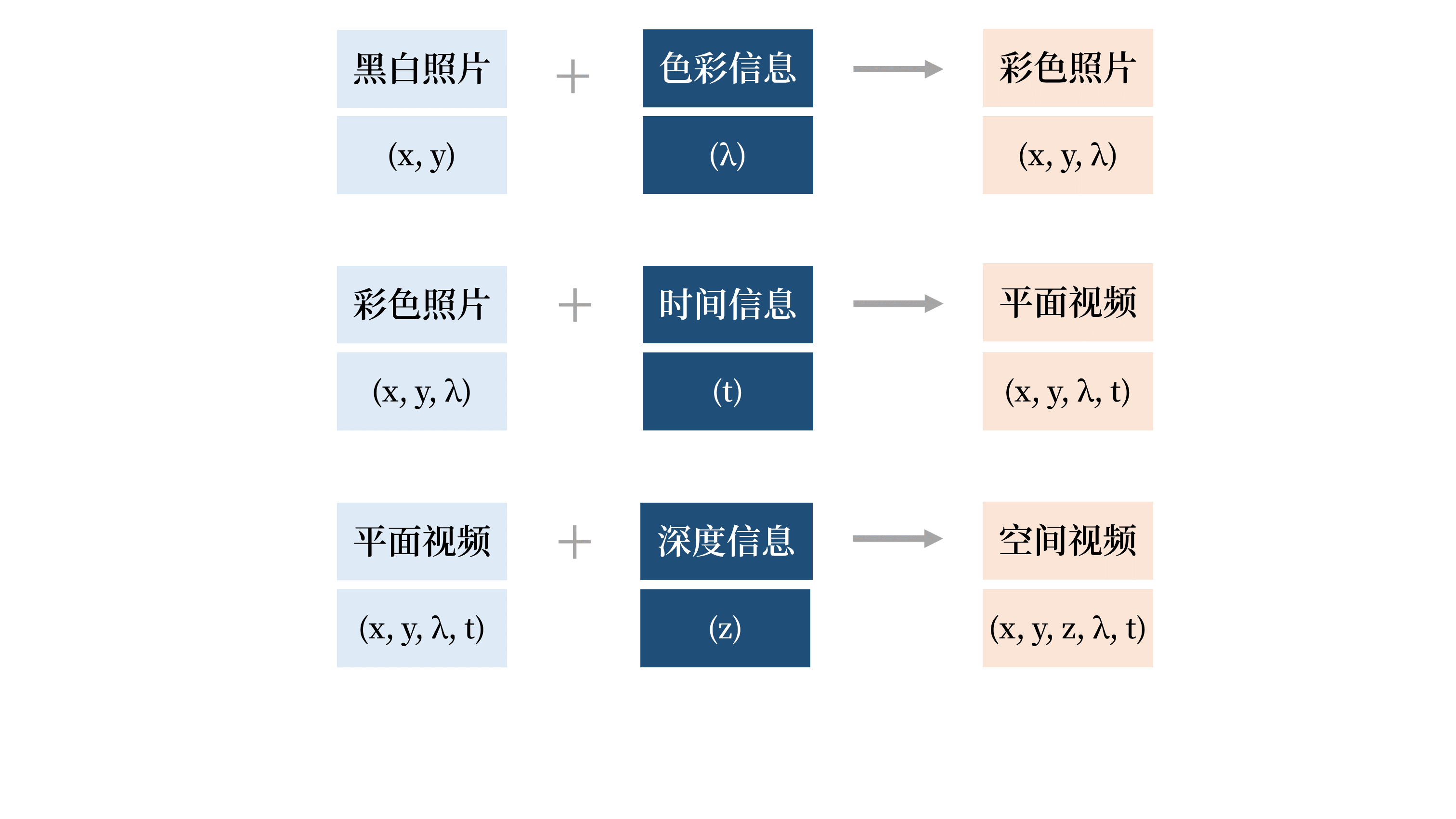

一开始是2维光场的黑白照片(x, y)。

加入色彩信息后,得到3维光场的彩色照片(x, y, λ)。

加入时间信息之后,得到4维光场的平面视频(x, y, λ, t)。

加入深度信息之后,得到5维光场的空间视频(x, y, z, λ, t)。

信息传递的维度不断增加,人类总是贪婪地索取着更多更快的信息,永不满足。

而科学技术也总会向着促使信息流动得更快更多的方向发展。

2. 超越算力不足

很多人都说VR没有「杀手级应用」,没有让人非它不可的理由。

但对于一个信奉「信息论」的人来说,我只需要关心有哪些信息的传递非它不可就行。

而答案已经很明显,就是基于双目视差的深度信息(z),这个维度的信息非它不可。

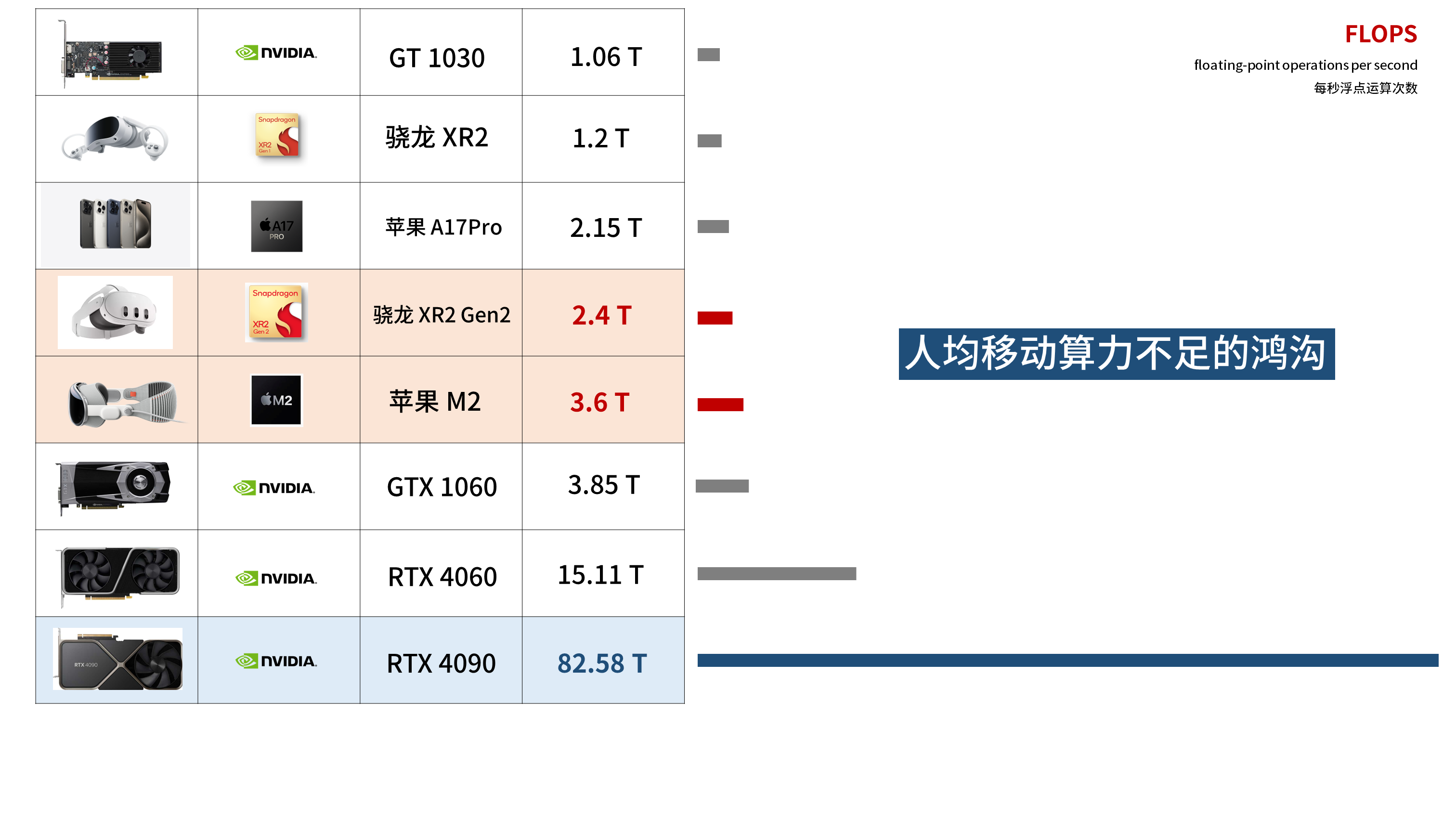

能察觉到这一点的人其实并不少,但是他们之中很少有人能够跨越过「人均算力不足」的鸿沟。

过去十多年的智能手机浪潮,可以看作是普及了1T FLOPS量级的「人均移动算力」,由此带来了移动互联网的繁荣。

但仅仅1T量级的移动算力,支撑不起「元宇宙」的愿景。

重建深度信息(z)需要远多得多的算力,无论谁想要做点什么,马上都会遇到算力不足的情况。

哪怕是苹果M2的3.6T算力,在「空间计算时代」也显得捉襟见肘,而代价已然是电池外置,并拖着一根不优雅的电源线。

但破局的点其实在于,机器可以在不理解深度信息的情况下,通过双目视差向人类传递深度信息。

VR只是一类「5维光场」显示器,但我们在渲染画面时,却常常不得不去构建「7维光场」的内容,重建全光函数P(x, y, z, θ, Φ, t, λ)的所有信息。

而事实上我们可以抛弃 (θ, Φ) ,只把注意力放在 (z) 上,

即抛弃视角上的自由度,而追求更大密度的深度信息。

这样就可以在有限的移动算力下,达成最大的信息丰富度。

所以我转向了「双目VR摄影」,并最终选择了可以将「深度信息」标准化的、以VR180为代表的球面3D影像。

可以说这就是我在过去很长一段时间内的思考脉络。

那么,然后呢?

3. 在几何之后

我们重新看回全光函数,P(x, y, z, θ, Φ, t, λ)

它实际上可以分成2个部分,几何和色彩。

对于VR显示来说也是如此。

在过去的十多年里,绝大部分人的关注重点都是在几何上。

清晰度,延迟,畸变,甜蜜点、眼盒……这些都只是VR显示的「几何」部分。

而在明白了VR影像的「几何」原理,拍摄了非常多的VR180影像之后,我发现自己最在意的东西开始转向了「色彩」。

这并非某种洞见,而来源于最直观的感受。

如果我们想要追求重建现实世界的「Vision」,那么就不可能无视色彩。

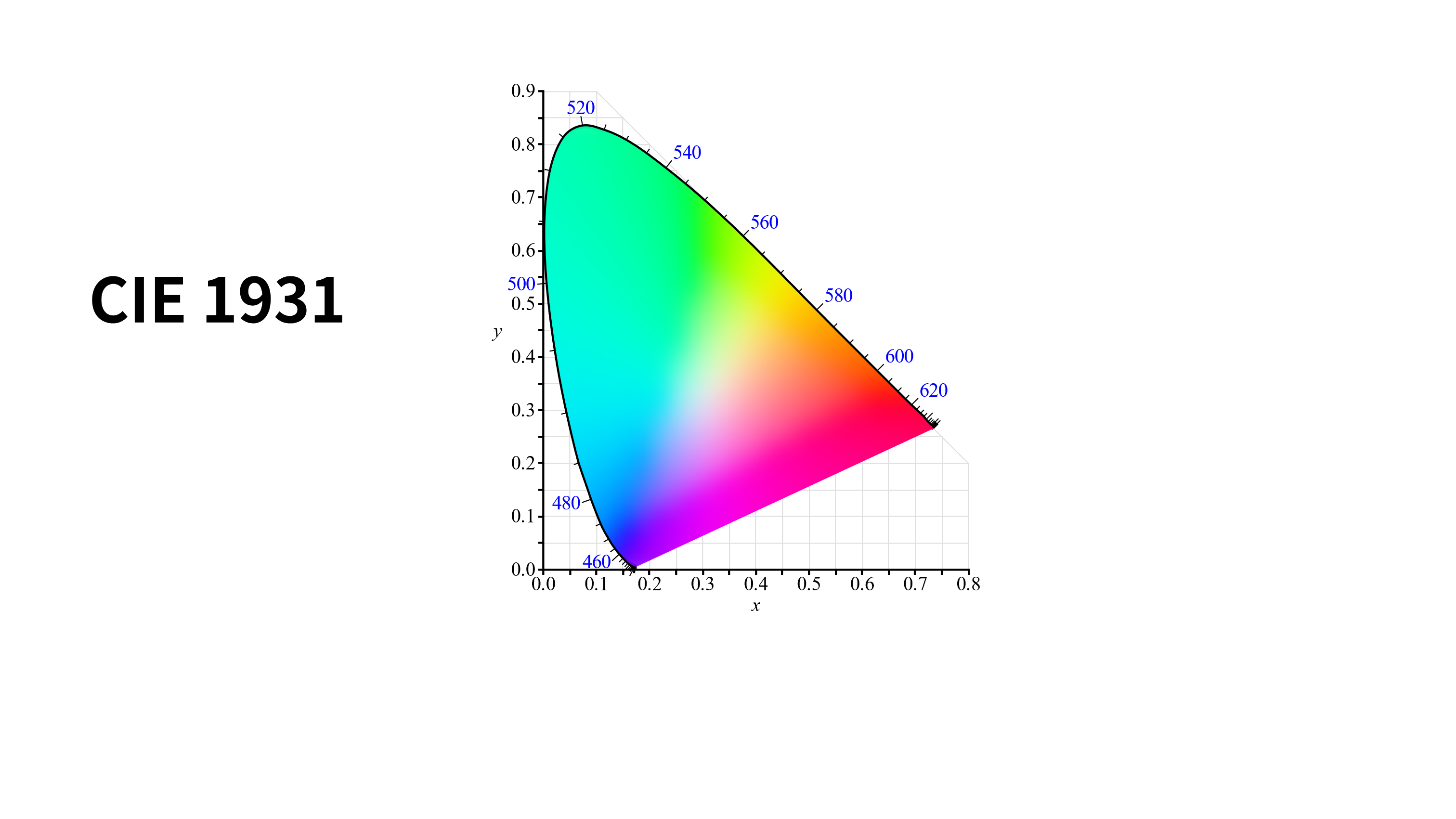

色彩是一种主观感知,物理学里并没有色彩,只有波长λ。

不同波长的光让人眼的3种视锥细胞产生不同的刺激,从而感知到主观的颜色。

巧的是,这和用「双目视差」去编码「深度信息」很像,我们不需要重建不同波长的光。而只需要用3种波长的光,以不同比例混合去刺激视锥细胞,就可以让人类感知到万千变化的色彩。

这就是现代RGB显示器所依托的底层原理。

这是一张CIE 1931 色度图,我们可以认为它覆盖了人眼能分辨出来的所有色彩。

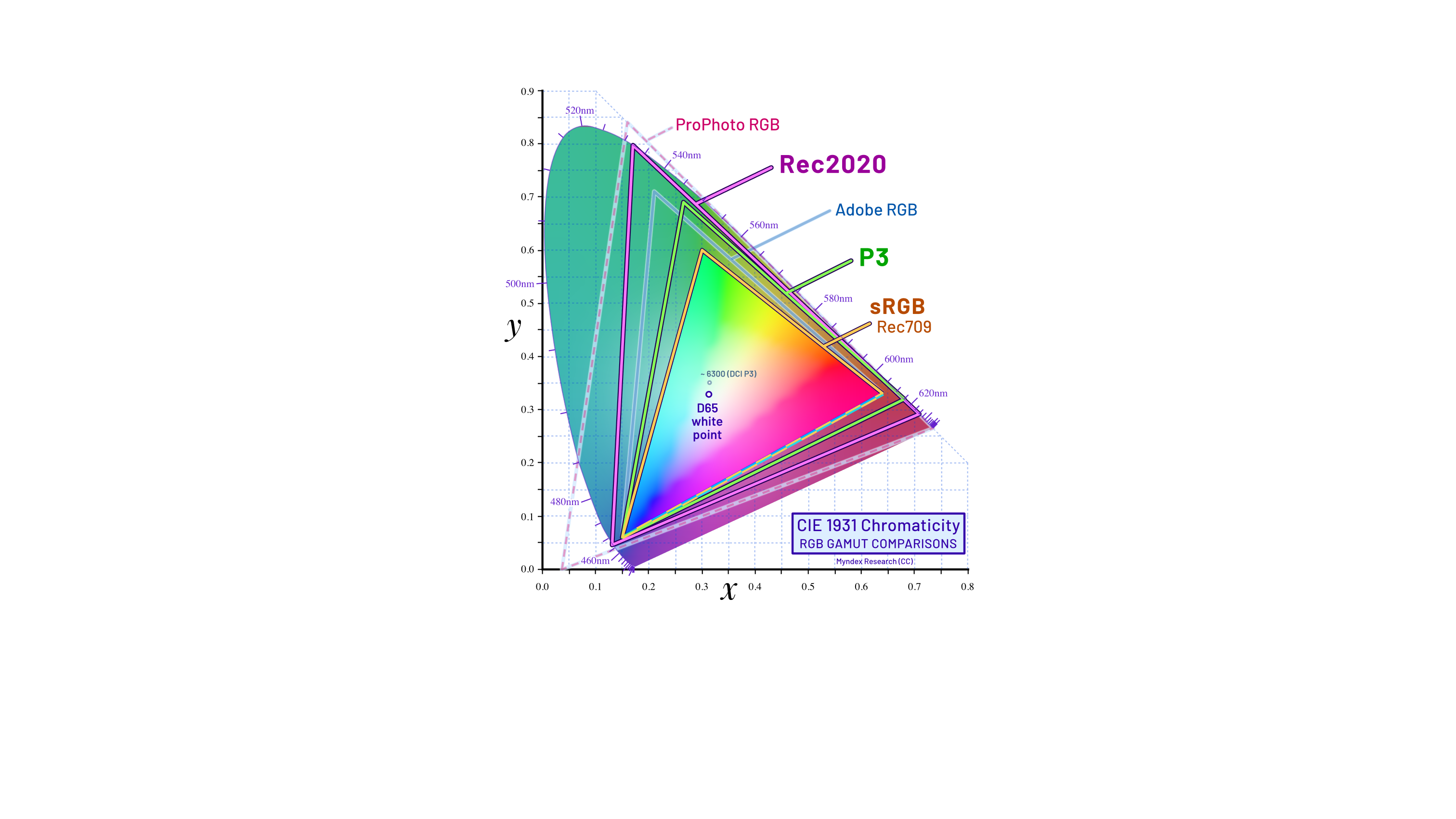

1996年,微软和惠普一起开发了应用于显示器、打印机和互联网的sRGB色彩空间,也就是图中的这个小三角形区域。

一直到今天,sRGB成了最广泛,最通用的色彩空间,但它其实只覆盖了CIE 1931 色度图的35%。

在28年后的今天,现代显示器已经完全可以显示更多的颜色,sRGB色彩空间早已是不够用的了。

而苹果从2015年开始在iMac上支持P3色域,一直到今天已经在全系产品上都支持了P3色域。

虽然也有其他产商也支持P3色域,但考虑到iPhone在全球10亿量级的持有量,可以说苹果在推动「色彩信息更多更快地流动」的这件事情上,有着不可估量的贡献。

但话说回来,P3色域其实也只覆盖了CIE 1931色度图53.6%的颜色。

而Vision Pro只支持92%的P3色域,换算过来大概也只占了人眼能看到的颜色的49%。

要完全再现人眼看到的「Vision」,这条路还只走了一半。

而除了色彩,亮度也是一个重要的维度。

苹果从2020年的iPhone12开始,支持杜比视界(Dolby Vision)规格的HDR视频拍摄,开始加速「亮度信息」的流动。

那亮度信息并不包含在全光函数的7个变量中,而是作为函数的值出现。

即全光函数 P(x, y, z, θ, ϕ, t, λ) 描述的是对于在(x, y, z)空间、(t)时间、 (θ, ϕ) 方向、(λ)波长的光,观察者能感知到的强度,也就是亮度。

我们在SDR的显示器里待久了,似乎忘了这个世界亮度的变化和色彩一样丰富。

可以说在传递「色彩信息」和「亮度信息」这两个领域里,苹果已经走了很远了。

它们都是构建「Vision」不可或缺的部分。

E. 通往Vision之路

回到开头的那个问题。

移动互联网的旧时代快要结束了,新世界在哪里?

我并不在意这些,但我能看到苹果站在了促进信息更多更快流动的正确方向上。

我很喜欢库克在接受《名利场》采访时说的那段话:

“我多年来就知道我们会达到这里。

我不知道什么时候,但我知道我们终会到达。”

“I’ve known for years we would get here.

I didn’t know when, but I knew that we would arrive here.”

《Why Tim Cook Is Going All In on the Apple Vision Pro》

https://www.vanityfair.com/news/tim-cook-apple-vision-pro

同样的,我不知道新世界在哪里。

但通往Vision之路,我们最终一定会抵达那里。

那这一期就到这里了。

我是HW君,我们下期再见。

(本章节完)

By HW君 @ 2024-04-13